AI x DePIN:火热赛道的碰撞将诞生哪些新机遇?

撰文:Cynic、Shigeru

本篇为 Web3 x AI 系列研报第二辑,先导篇详见《从平行走向交汇:探索「Web3 与 AI 融合」引领的数字经济新浪潮》

随着世界迈向数字化转型的步伐不断加快,AI 和 DePIN( 去中心化物理基础设施 ) 已成为推动各行各业变革的基础性技术。AI 与 DePIN 的融合,不仅能够促进技术的快速迭代和应用广泛化,还将开启更为安全、透明和高效的服务模式,为全球经济带来深远的变革。

DePIN:去中心化脱虚向实,数字经济中流砥柱

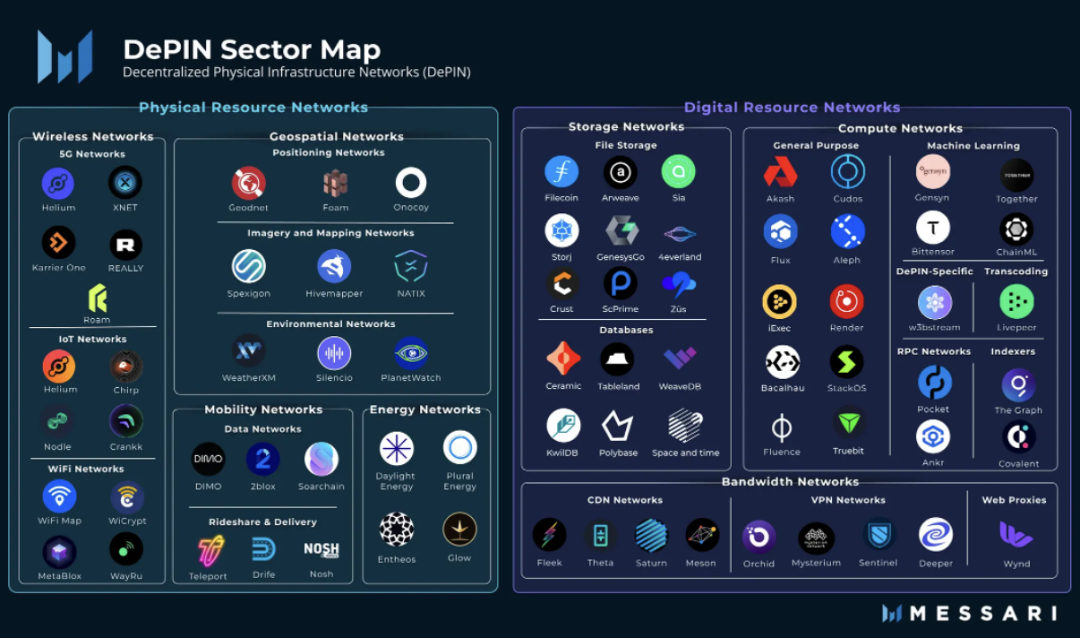

DePIN,是去中心化物理基础设施(Decentralized Physical Infrastructure)的缩写。从狭义上说,DePIN 主要指由分布式账本技术支撑的传统物理基础设施的分布式网络,例如电力网络、通信网络、定位网络等。从广义上说,所有由物理设备支撑的分布式网络都可以称之为 DePIN,例如存储网络、计算网络。

from: Messari

如果说 Crypto 在金融层面带来了去中心化的变革,那么 DePIN 就是实体经济中的去中心化方案。可以说,PoW 矿机,就是一种 DePIN。从第一天起,DePIN 就是 Web3 的核心支柱。

AI 三要素——算法、算力、数据,DePIN 独占其二

人工智能的发展通常被认为依赖于三个关键的要素:算法、算力和数据。算法指驱动 AI 系统的数学模型和程序逻辑,算力指执行这些算法所需的计算资源,数据是训练和优化 AI 模型的基础。

三要素中哪个最重要?chatGPT 出现之前人们小白导航通常认为是算法,不然学术会议、期刊论文也不会被一篇又一篇的算法微调所填充。可当 chatGPT 与支撑其智能的大语言模型 LLM 亮相之后,人们开始意识到后两者的重要性。海量的算力是模型得以诞生的前提,数据质量和多样性对于建立健壮和高效的 AI 系统至关重要,相比之下,对于算法的要求不再如往常精益求精。

在大模型时代,AI 从精雕细琢变为大力飞砖,对算力与数据的需求与日俱增,而 DePIN 恰好能够提供。代币激励撬动长尾市场,海量的消费级算力与存储将成为大模型提供最好的养料。

AI 的去中心化不是可选项,而是必选项

当然有人会问,算力和数据,在 AWS 的机房中都有,而且在稳定性、使用体验方面都胜过 DePIN,为什么要选择 DePIN 而不是中心化的服务?

这种说法自然有其道理,毕竟纵观当下,几乎所有大模型都是由大型的互联网企业直接或间接开发的,chatGPT 的背后是微软,Gemini 的背后是谷歌,中国的互联网大厂几乎人手一个大模型。为何?因为只有大型的互联网企业拥有足够的优质数据与雄厚财力支撑的算力。但这是不对的,人们已经不想再被互联网巨头操纵一切。

一方面,中心化的 AI 具备数据隐私和安全风险,可能受到审查与控制;另一方面,互联网巨头制造的 AI 会使人们进一步加强依赖性,并且导致市场集中化,提高创新壁垒。

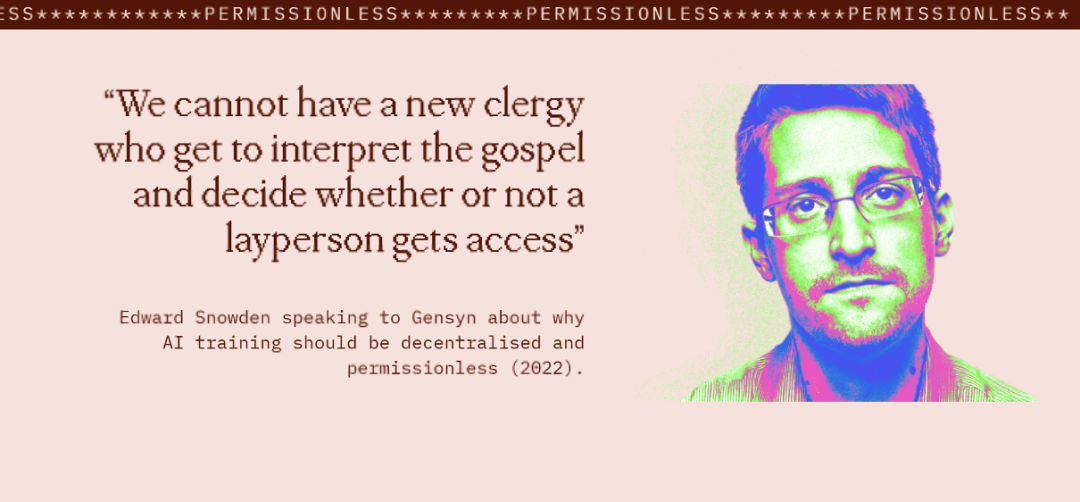

from: https://www.gensyn.ai/

人类不应该需要一个 AI 纪元的马丁路德了,人们应该有权利直接和神对话。

商业角度看 DePIN:降本增效是关键

哪怕抛开去中心化与中心化的价值观之争,从商业角度来看,将 DePIN 用于 AI 仍然有其可取之处。

首先,我们需要清晰地认识到,尽管互联网巨头手中掌握了大量的高端显卡资源,散入民间的消费级显卡组合起来也能构成非常可观的算力网络,也就是算力的长尾效应。这类消费级显卡,闲置率其实是非常高的。只要 DePIN 给到的激励能超过电费,用户就有动力为网络贡献算力。同时,所有物理设施被用户自身所管理,DePIN 网络无需负担中心化供应商无法避免的运营成本,只需关注协议设计本身。

对于数据而言,DePIN 网络通过边缘计算等方式,能够释放潜在数据的可用性,降低传输成本。同时,多数分布式存储网络而言具备自动去重功能,减少了 AI 训练数据清洗的工作。

最后,DePIN 所带来的 Crypto 经济学增强了系统的容错空间,有望实现提供者、消费者、平台三赢的局面。

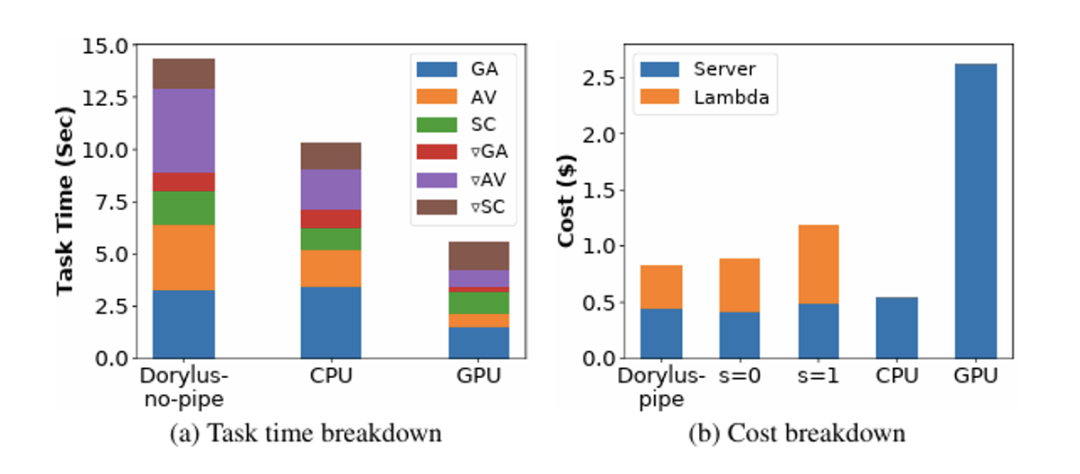

from: UCLA

以防你不相信,UCLA 最新的研究表明相同成本下使用去中心化计算相比传统 GPU 集群实现了 2.75 倍的性能,具体来说,快了 1.22 倍且便宜 4.83 倍。

筚路维艰:AIxDePIN 会遇到哪些挑战?

We choose to go to the moon in this decade and do the other things, not because they are easy, but because they are hard.——John Fitzgerald Kennedy

运用 DePIN 的分布式存储与分布式计算无信任地构建人工智能模型仍然具备许多挑战。

工作验证

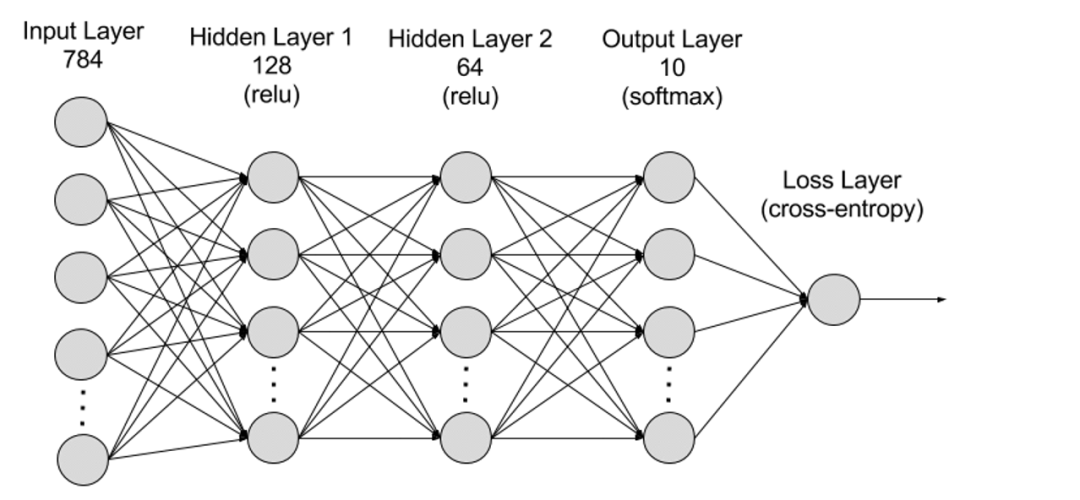

从本质上,计算深度学习模型与 PoW 挖矿都是通用计算,最底层都是门电路之间的信号变化。宏观而言,PoW 挖矿是「无用的计算」,通过无数的随机数生成与哈希函数计算试图得出前缀有 n 个 0 的哈希值;而深度学习计算是「有用的计算」,通过前向推导与反向推导计算出深度学习中每层的参数值,从而构建一个高效的 AI 模型。

事实是,PoW 挖矿这类「无用的计算」使用了哈希函数,由原像计算像很容易,由像计算原像很难,所以任何人都能轻易、快速地验证计算的有效性;而对于深度学习模型的计算,由于层级化的结构,每层的输出都作为后一层的输入,因此验证计算的有效性需要执行之前的所有工作,无法简单有效地进行验证。

from: AWS

工作验证是非常关键的,否则,计算的提供者完全可以不进行计算,而提交一个随机生成的结果。

有一类想法是让不同的服务器执行相同计算任务,通过重复执行并检验是否相同来验证工作的有效性。然而,绝大多数模型计算是非确定性的,即使在完全相同的计算环境下也无法复现相同结果,只能在统计意义上实现相似。另外,重复计算会导致成本的快速上升,这与 DePIN 降本增效的关键目标不相符。

另一类想法是 Optimistic 机制,先乐观地相信结果是经过有效计算的,同时允许任何人对计算结果进行检验,如果发现有错误,可以提交一个 Fraud Proof,协议对欺诈者进行罚没,并对举报者给予奖励。

并行化

之前提到,DePIN 撬动的主要是长尾的消费级算力市场,也就注定了单个设备所能提供的算力比较有限。对于大型 AI 模型而言,在单个设备上进行训练的时间会非常长,必须通过并行化的手段来缩短训练所需时间。

深度学习训练的并行化主要的难点在于前后任务之间的依赖性,这种依赖关系会导致并行化难以实现。

当前,深度学习训练的并行化主要分为数据并行与模型并行。

数据并行是指将数据分布在多台机器上,每台机器都保存一个模型的全部参数,使用本地的数据进行训练,最后对各个机器的参数进行聚合。数据并行在数据量很大时效果好,但需要同步通信来聚合参数。

模型并行是当模型大小太大无法放入单个机器时,可以将模型分割在多台机器上,每台机器保存模型的一部分参数。前向和反向传播时需要不同机器之间通信。模型并行在模型很大时有优势,但前后向传播时的通信开销大。

对于不同层之间的梯度信息,又可以分为同步更新与异步更新。同步更新简单直接,但是会增加等待时间;异步更新算法等待时间短,但是会引入稳定性问题。

from: Stanford University, Parallel and Distributed Deep Learning

隐私

全球正在掀起保护个人隐私的思潮,各国政府都在加强对个人数据隐私安全的保护。尽管 AI 大量使用公开数据集,真正将不同 AI 模型区分开的还是各企业专有的用户数据。

如何在训练过程中得到专有数据的好处同时不暴露隐私?如何保证构建的 AI 模型参数不被泄露?

这是隐私的两个方面,数据隐私与模型隐私。数据隐私保护的是用户,而模型隐私保护的是构建模型的组织。在当前的情况下,数据隐私比模型隐私重要得多。

多种方案正在尝试解决隐私的问题。联邦学习通过在数据的源头进行训练,将数据留在本地,而模型参数进行传输,来保障数据隐私;而零知识证明可能会成为后起之秀。

案例分析:市场上有哪些优质项目?

Gensyn

Gensyn 是一个分布式计算网络,用于训练 AI 模型。该网络使用基于 Polkadot 的一层区块链来验证深度学习任务是否已正确执行,并通过命令触发支付。成立于 2020 年,2023 年 6 月披露一笔 4300 万美元的 A 轮融资,a16z 领投。

Gensyn 使用基于梯度的优化过程的元数据来构建所执行工作的证书,并由多粒度、基于图形的精确协议和交叉评估器一致执行,以允许重新运行验证工作并比较一致性,并最终由链本身确认,来保证计算的有效性。为了进一步加强工作验证的可靠性,Gensyn 引入质押来创建激励。

系统中有四类参与者:提交者、求解者、验证者和举报者。

-

提交者是系统的终端用户,提供将要计算的任务,并为已完成的工作单元付费。

-

求解器是系统的主要工作者,执行模型训练并生成证明以供验证者检查。

-

验证器是将非确定性训练过程与确定性线性计算联系起来的关键,复制部分求解器证明并将距离与预期阈值进行比较。

-

举报人是最后一道防线,检查验证者的工作并提出挑战,挑战通过后获得奖励。

求解者需要进行质押,举报者检验求解者的工作,如发现作恶,进行挑战,挑战通过后求解者质押的代币被罚没,举报者获得奖赏。

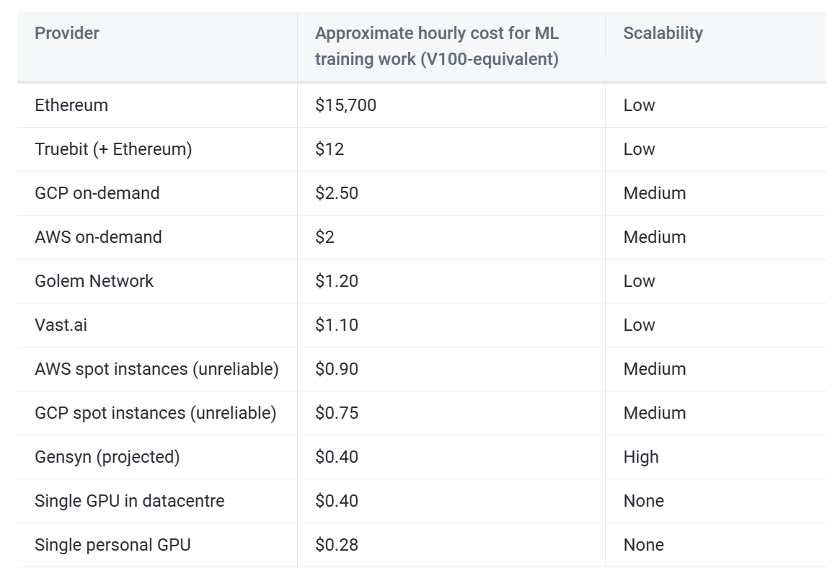

根据 Gensyn 的预测,该方案有望将训练成本降至中心化供应商的 1/5。

from: Gensyn

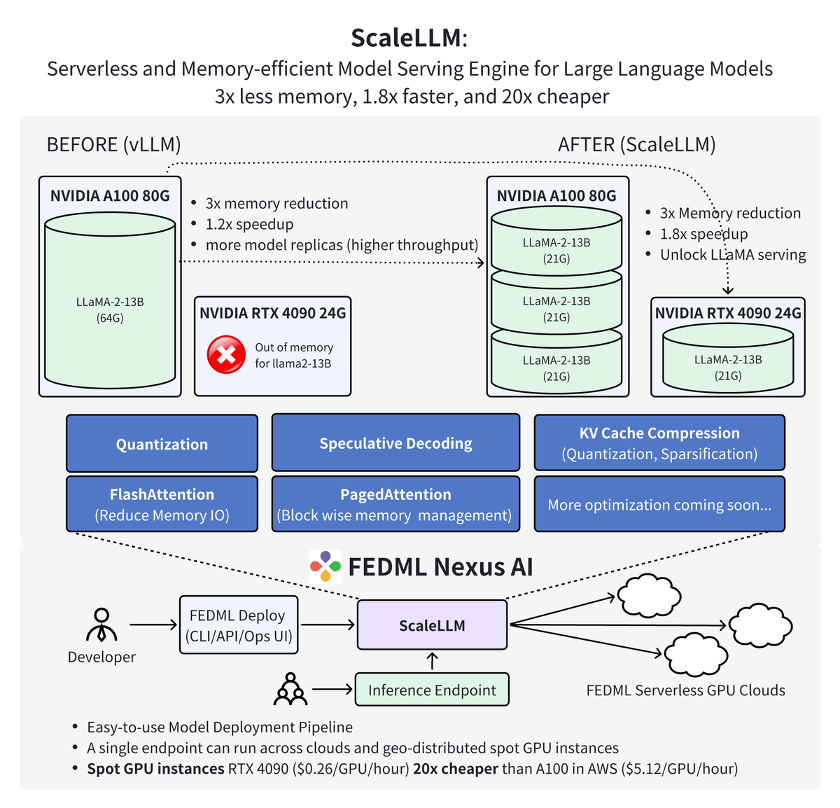

FedML

FedML 是一个去中心化协作的机器学习平台,用于在任何地方以任何规模进行去中心化和协作式 AI。更具体地说,FedML 提供了一个 MLOps 生态系统,可以训练、部署、监控和持续改进机器学习模型,同时以保护隐私的方式在组合数据、模型和计算资源上进行协作。成立于 2022 年,FedML 于 2023 年 3 月披露 600 万美元的种子轮融资。

FedML 由 FedML-API 和 FedML-core 两个关键组件构成,分别代表高级 API 和底层 API。

FedML-core 包括分布式通信和模型训练两个独立的模块。通信模块负责不同工作者 / 客户端之间的底层通信,基于 MPI;模型训练模块基于 PyTorch。

FedML-API 建立在 FedML-core 之上。借助 FedML-core,可以通过采用面向客户端的编程接口轻松实现新的分布式算法。

FedML 团队最新的工作中证明,使用 FedML Nexus AI 在消费级 GPU RTX 4090 上进行 AI 模型推理,比 A100 便宜 20 倍,快 1.88 倍。

from: FedML

未来展望:DePIN 带来 AI 的民主化

有朝一日,AI 进一步发展为 AGI,彼时算力将成为事实上的通用货币,DePIN 使得这一过程提前发生。

AI 和 DePIN 的融合开启了一个崭新的技术增长点,为人工智能的发展提供了巨大的机遇。DePIN 为 AI 提供了海量的分布式算力和数据,有助于训练更大规模的模型,实现更强的智能。同时,DePIN 也使 AI 向着更加开放、安全、可靠的方向发展,减少对单一中心化基础设施的依赖。

展望未来,AI 和 DePIN 将不断协同发展。分布式网络将为训练超大模型提供强大基础,这些模型又将在 DePIN 的应用中发挥重要作用。在保护隐私和安全的同时,AI 也将助力 DePIN 网络协议和算法的优化。我们期待着 AI 和 DePIN 带来更高效、更公平、更可信的数字世界。

文章来源于互联网:AI x DePIN:火热赛道的碰撞将诞生哪些新机遇?

相关推荐: MT Capital 研报:Fair Launch,代币发行方式的深刻变革

不依赖于平台币或投资者,最早期的参与者即完成了项目的投资、分发、市场推广和布道。 作者:Xinwei, Ian TL;DR 在过去的几年中,区块链行业经历了翻天覆地的变化,尤其在代币发行方式上出现了显著的革新。从最初简单的ICO到复杂的DeFi结构,再到今天的…